NVIDIA Grafikprozessoren als KI-Turbo in der Wissenschaft

Mit leistungsstarken GPU-Computing-Ressourcen von NVIDIA können Wissenschaftler Künstliche Intelligenz, maschinelles Lernen und Datenwissenschaft nutzen, um das Wissen in ihren jeweiligen Forschungsbereichen noch schneller zu erweitern und zu vertiefen.

Europa im KI-Hintertreffen?

Beim Thema digitale Transformation schneidet Europa vergleichsweise schlecht ab. Eine McKinsey-Studie vom Februar 2019 besagt, dass europäische Unternehmen nur etwa 12% ihres digitalen Potentials ausschöpfen. Besonders was die neuesten Technologien zu Künstlicher Intelligenz betreffen, liegt Europa weit hinter China und den USA. Insgesamt nutzen weniger als die Hälfte aller europäischen Firmen KI-Technologien, und davon befinden sich die meisten auch noch in der Pilotphase. Das ist besonders vor dem Hintergrund interessant, dass die meisten wissenschaftlichen Papiere zum Thema KI in Europa veröffentlicht werden: Über 17.000 waren es 2017, in China gab es immer noch 15.000 und in den USA etwa 10.000 Veröffentlichungen zu KI, so berichtet das Handelsblatt im April 2019. Doch nicht nur theoretisch befasst sich die europäische Wissenschaft mit KI, in beinahe allen Bereichen der Forschung wird sie erfolgreich eingesetzt. Wir haben hier einige beeindruckende Beispiele aus Europa zusammengestellt und stellen ein deutsches Leuchtturmprojekt (DFKI) vor.

Kernfusion verstehen

Eine leistungsfähigere und sauberere (frei von radioaktiven Abfällen) Alternative zur Kernspaltung ist die Kernfusion, die Zusammenführung von Atomkernen. Doch bislang sind die Wissenschaftler nicht in der Lage, eine Kernfusionsreaktion lange genug aufrechtzuerhalten, um ihre Energie zu nutzen. Mit Hilfe von Deep-Learning-Algorithmen und Tesla P100-Grafikprozessoren untersuchen Universitätsforscher des portugiesischen Técnico Lisboa die Form und das Verhalten des Plasmas in einem Fusionsreaktor. Wenn die Forscher in der Lage sind, vorherzusagen, wann eine Reaktion kurz vor einer Störung steht, könnten sie vorbeugende Maßnahmen ergreifen, um die Reaktion so lange zu verlängern, bis enorme Mengen an Energie abgeschöpft werden können. GPUs sind unerlässlich, um diese auf neuronalen Netzwerken basierenden Inferenzen in Echtzeit während einer Fusionsreaktion durchzuführen. Die Deep-Learning-Modelle prognostizieren derzeit Störungen mit einer Genauigkeit von 85%. Durch das Hinzufügen weiterer Sonden, die Messungen im Reaktor sammeln, und die Verwendung eines Multi-GPU-Systems können die Forscher noch höhere Genauigkeitswerte erzielen.

100-mal schnellere Kernforschung

Physiker sind seit langem auf der Suche nach der „Theory of Everything“, einem mathematischen Modell, das universell funktioniert, auch bei Geschwindigkeiten mit annähernd Lichtgeschwindigkeit. Das CERN, die Europäische Organisation für Kernforschung, ist ein wichtiges Zentrum für diese Forschung. „Wir arbeiten daran, unsere Software zu beschleunigen und ihre Genauigkeit zu verbessern.“ Mit Hilfe dieser Software werden Interaktionen simuliert, die bei der Teilchenkollision auftreten. „Wir versuchen, den Herausforderungen in der nächsten Phase unseres Large Hadron Collider (Teilchenbeschleuniger) bestmöglich zu begegnen“, sagt CERN-Forscher Andrea Bocci. „Wir untersuchen den Einsatz von GPUs, um unsere Algorithmen zu beschleunigen und schnelle Inferenz aus Deep-Learning Modellen in unser real-time Data Processing System der nächsten Generation zu integrieren.“ Die Verwendung von GPUs wird es dem CERN ermöglichen, die Messlatte für detaillierte und hochpräzise Analysen höher zu legen und bis zu 100-mal schneller zu sein als heute.

Sonnensystemerkundung mit Multi-KHz-Bildrate

Astronomen nutzen große Teleskope, um den Himmel nach Planeten außerhalb des Sonnensystems abzusuchen. Aber die Atmosphäre unseres Planeten ist turbulent und verzerrt die Bilder, die von bodengebundenen Teleskopen aufgenommen werden. Um dieser Verzerrung entgegenzuwirken, verwenden Astronomen deformierbare Spiegel, die sich in Echtzeit formen können. Eine Kombination aus linearer Algebra und maschinellen Lernalgorithmen bestimmt, wie sich das Teleskop bewegen muss, um die atmosphärische Verzerrung zu korrigieren, aber sie müssen extrem schnell sein, da sich die Verzerrung ständig ändert. Die Algorithmen müssen vorhersagen, wie die Verzerrung genau dann aussehen wird, wenn sich die deformierbaren Spiegel in die richtige Form verschieben. Forscher des Observatoire de Paris in Zusammenarbeit mit Subaru Telescope und KAUST ECRC verwenden NVIDIA DGX-1 AI-Supercomputer, um die Inferenzierung der Algorithmen mit der erforderlichen Multi-KHz-Bildrate durchzuführen.

Erkenntnisse zur Erderwärmung

Ein neuer Bericht des Intergovernmental Panel on Climate Change Description warnt vor katastrophalen Auswirkungen, wenn die globale Temperatur oberhalb 1,5 Grad Celsius über das vorindustrielle Niveau steigt. Um diese Prognosen zu erstellen, stützen sich die Forscher auf Klimamodelle, die Jahre in die Zukunft und auf große geografische Gebiete blicken. Diese sind allerdings derart rechenintensiv, dass Wissenschaftler oft eine geringe Auflösung verwenden und dann Rückschlüsse auf eine Ebene von mehreren Quadratkilometern ziehen. Um die Einzelfaktoren, welche die Klimamodelle beeinflussen, besser berechnen zu können, lässt das Schweizer National Supercomputing Center sein Modell auf dem Piz Daint, dem schnellsten Supercomputer Europas, laufen. Das System ist mit mehr als 5.000 Tesla P100-GPUs ausgestattet. Piz Daint ermöglicht es den Forschern des Zentrums, ein globales Klimamodell mit einer Auflösung von einem Quadratkilometer durchzuführen. Diese genauere Klimamodellierung lässt die Auswirkungen der globalen Erwärmung besser verstehen.

Schadensbegrenzung bei Naturkatastrophen

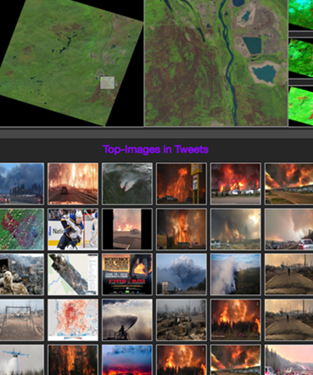

Das führende deutsche Forschungszentrum für Künstliche Intelligenz (DFKI) ist die erste Institution in Europa, die das NVIDIA DGX-2 AI-System mit 16 Tesla V100 Tensor Core-GPUs eingesetzt hat. Das DFKI nutzt Deep Learning, um hierzulande die Schäden von Naturkatastrophen wie Hochwasser und Waldbränden abzuschätzen. Das Vorgehen folgt einem multimodalen Ansatz, bei dem Daten und Erkenntnisse aus unterschiedlichsten Quellen miteinander in Korrelation gesetzt und verknüpft werden.

Es werden beispielsweise unterschiedliche Frequenzbänder der Satelliten mit RGB- oder Infrarot-Werten verwendet und selbst Multimedia-Einträge in sozialen Netzwerken werden online und in Echtzeit ausgewertet, um das Ausmaß von Krisen zu messen. „Die Zeit ist entscheidend für jede Beurteilung einer Krisensituation“, sagt Andreas Dengel, Standortleiter am DFKI. „NVIDIAs DGX ermöglicht es uns, Satellitenbilder für Bereiche, die am Boden möglicherweise nicht mehr zugänglich sind, in Echtzeit zu analysieren.“ Diese schnellen Erkenntnisse helfen dann im Ernstfall Ersthelfern, schneller und effizienter zu entscheiden, wo und wie sie nach einer Naturkatastrophe Hilfe und Ressourcen einsetzen können.

Tiefer forschen

Diese Auswahl an Beispielen zeigt einmal mehr, welch enormes Potential in Künstlicher Intelligenz steckt. In der Wissenschaft eingesetzt, trägt sie nicht nur dazu bei, unsere Umwelt besser zu verstehen, sondern verhilft uns zu tiefen Erkenntnissen, die Leben retten können.

Jetzt NVIDIA Webinar ansehen und wertvolle Erkenntnisse gewinnen

Microstaxx stellt Ihnen eine Aufzeichnung des Webinars, NVIDIA Academic Program for AI in Higher Education and Research in Deutscher Sprache zur Verfügung (Dauer: ca. 20 Minuten). Darin beschreibt Ralph Hinsche, Business Development for Higher Education and Research in Central Region NVIDIA, die empfohlene Infrastruktur und die Programme, die akademischen Einrichtungen zur Verfügung stehen, um ihre Forschung zu beschleunigen und Entdeckungen voranzutreiben.

NVIDIA DGX-1 ist heute das essentielle Instrument für Ihre Forschung mit Hilfe von Künstlicher Intelligenz. Wie Sie Ihre Infrastruktur schnell und gezielt auf eine maximal leistungsfähige KI-Plattform skalieren, ohne die Verwaltungskosten in die Höhe zu treiben, erfahren Sie im Datenblatt NVIDIA DGX-1 (Englisch).

Bildquelle: NVIDIA Blog